Na verdade, a única parte que fica "verificada" é o link do site presente na bio do mastodon.

Então no seu site pessoal (https://fulanodetal.com.zz), você precisa adicionar um link apontando pro seu mastodon, com a tag rel="me" (<a href="https://algumainstanciadomastodon.com.zz/@fulanodetal" rel="me">Meu Mastodon</a>) e depois no seu perfil do mastodon você adiciona o link do seu site(https://fulanodetal.com.zz) e automagicamente o link era pra aparecer verdinho na sua bio.

Mas acho que isso só vai afetar o link na bio/perfil do mastodon, pelo que eu saiba, pra ficar como SeuUsuário@fulanodetal.com.zz seria necessário que você hospedasse uma instância própria no seu site.

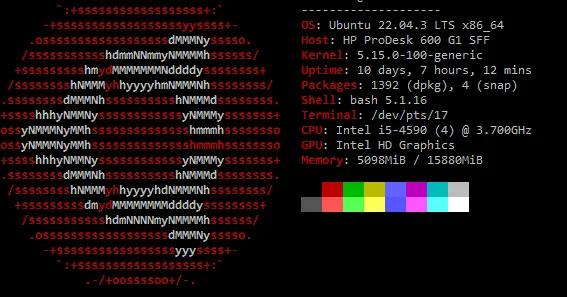

No meu caso foi reaproveitando PC velho mesmo, inclusive era tudo com os gabinetes grandões todo sucateado.

Mas dependendo da verba, até um raspberry pi pode ser interessante pra começar a mexer.

O legal do raspberry é que basta você trocar um cartão SD que você consegue ter um sistema operacional diferente. Então quando quiser brincar como servidor, coloca um cartão SD com um ubuntu server da vida e nem precisa ligar num monitor.

E se gostar de jogar joguinhos antigos, bota um SD com batocera ou coisa do tipo e liga numa tela via HDMI pra jogar uns Super Nintendo ou assistir coisas pelo Kodi.

Acho que raid seja uma alternativa?

No meu caso, raid "desperdiçaria" muito hdd, então eu vou na fé e só programo as coisas mais importantes pra rodar uns backups periodicamente e salvar numa pasta que tá sincronizada via syncthing com o meu desktop.